Les sites qui trustent les premières positions dans l’index de Google sont bien évidemment optimisés pour le référencement naturel. Mais sont-ils pour autant réellement un amas de bonnes pratiques ? Pas nécessairement…

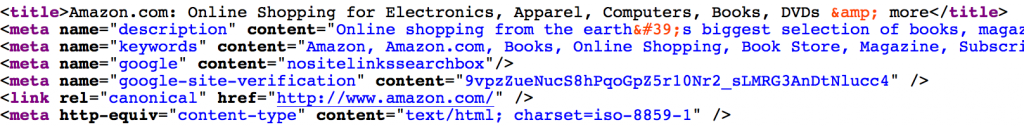

L’exemple d’Amazon.com

Dans cet article publié sur searchengineland.com, Tom Schmitz démontre que si l’on souhaitait copier les pratiques mises en place par Amazon sur sa homepage, on se ferait probablement plus de mal que de bien.

Cela est dû à plusieurs choses, comme il l’explique :

- Amazon a une équipe d’experts SEO qui connait parfaitement les critères de l’algorithme de Google

- Ils connaissent par ailleurs naturellement le contenu du site Amazon mieux que quiconque

- Ils connaissent également la structure technique et organisationnelle du site mais aussi des pages du sites.

- Et donc l’un dans l’autre, ils connaissent les réactions de Google vis-à-vis des différentes implémentations SEO (spécifiques à Amazon) qu’ils peuvent faire à différents endroits.

Demain si j’essaye donc de copier les pratiques mises en place par Amazon, je me coupe des 3 derniers points qui sont pourtant cruciaux et me limiter au premier point, à savoir la connaissance théorique de l’équipe SEO d’Amazon de l’algorithme de Google, serait une erreur de jugement.

Tout n’est bien évidemment pas à jeter et il reste des bonnes idées à attraper mais le SEO de son site ne doit pas être calqué d’un top site, mais plutôt inspiré tout au plus.

Où regarder et qui copier ?

Si vous avez (ou votre prestataire) quelques connaissances SEO, il y a fort à parier que copier n’apportera pas grand chose de bien, du moins pas autant que vous pourriez l’espérer.

« Je vais faire comme mon concurrent mais en plus grande quantité et en mieux ». Cette pensée qu’on pourrait trouver légitime au premier abord fait en réalité obstruction de plusieurs points :

- Le passif de chacun des sites

- La notion de popularité et de trustrank

En théorie, une stratégie SEO doit être unique et propre à chaque site. J’optimise mon site pour mettre mon contenu en valeur (au sens large du terme : mes produits, mes contenus textuels, mes images, etc.) et mon contenu est censé être unique, du moins dans sa globalité.

La réalisation et la définition d’une stratégie SEO est un autre sujet qui demanderait un article (et bien plus) à proprement parlé.

Malgré tout, il est possible de s’inspirer fortement, voir de copier (n’ayons pas peur du mot) certaines techniques spécifiques ou certaines idées structurantes.

Que copier ?

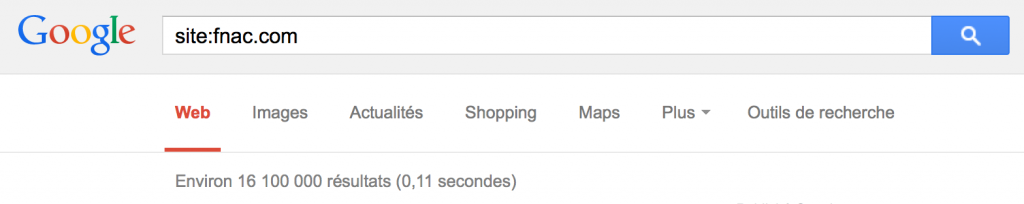

Il y a des choses qui sont souvent intéressantes à observer chez un concurrent ou plus généralement chez un site performant. Ainsi, la première chose que j’aime bien regarder, c’est la notion de qualité que peut percevoir Google d’un site. Un moyen rapide de le faire c’est d’utiliser la fameuse commande « site: » dans Google en ajoutant évidemment (et sans espace) l’URL de votre concurrent.

En regardant le nombre de résultats retournés, on saura alors le nombre de pages indexées par Google :

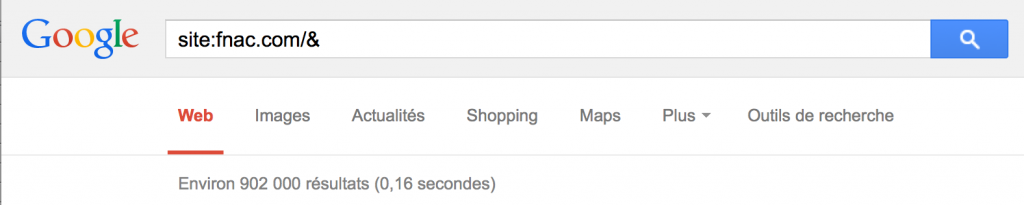

Maintenant, en rajoutant « /& » à la fin de l’URL, je demande à Google de ne me retourner que les résultats qu’il juge pertinent et donc qu’il valorise un minimum.

En divisant le résultat filtré par le résultat global, j’obtiens un pourcentage de pages qualitatives perçues par Google. Si ce pourcentage est bas, alors je sais d’avance que j’aurai peu de choses à tirer d’une analyse plus détaillée de ce site. Inversement, plus on s’approche des 100%, plus ce site est propre et bien perçu par Google, et plus j’aurai à apprendre en le décortiquant.

Dans l’optique où ce pourcentage est élevé et donc que je m’intéresse au site en question, j’aurai tout de suite envie de regarder son architecture (et/ou son arborescence) et la navigation qui en découle. En effet, un site qualitatif de nos jours aux yeux de Google (et des internautes ?), c’est un site bien construit, avec du contenu qualitatif et bien organisé (en silo par exemple).

Si j’arrive facilement à identifier cette architecture et cette navigation et qu’elles me paraissent logiques, alors je pourrai fortement m’en inspirer pour la création/modification de celles de mon site.

De manière plus générale, si je m’intéresse à un type de page en particulier (par exemple des pages produits qui performent tandis que les miennes ne génèrent aucun trafic), alors je peux focaliser mes efforts, toujours en tenant compte de ce fameux pourcentage, sur les pages qui m’intéressent. Je peux même réitérer l’expérience du « site: » en précisant non pas l’adresse de la page d’accueil mais un repertoire spécifique qui contiendrait les pages qui m’intéressent.

Je regarderai ici particulièrement l’organisation techniques de la page et de son contenu, ainsi que la navigation interne de la page.

Pour reprendre mon exemple ci-dessus, à savoir le site FNAC.com, il obtient si j’en crois la méthode ci-dessus, 6% de pages qualitatives environ. Ses performances ne sont ainsi peut-être pas aussi bonnes qu’elles pourraient l’être et m’y intéresser pour copier certaines techniques n’est en l’occurence ici pas nécessairement la meilleure chose à faire.

Si je réitère l’expérience avec cette fois cdiscount.com, je vais me rendre compte que ce pourcentage tourne plutôt autour des 100% : j’aurai alors probablement bien plus à apprendre de ce dernier que de FNAC.com.

Vous apprécierez peut-être également:

- 10 points à regarder pour analyser le SEO d’un site

- Les Adwords auxquels on ne pense pas assez

- SEO : peut-on réellement optimiser une homepage ?

- Le nombre de pages idéal en SEO

- Comment identifier clairement les problèmes SEO d’un site ?

C’est marrant comme deux référenceurs peuvent penser à deux choses différentes en matière de copie d’un site.

Personnellement j’ai tout de suite pensé à la copie du profil de liens…

Cependant ton analyse est intéressante, et je ne connaissais pas la commande /& donc merci pour l’info!

Etonnant cette façon de faire. J’ai jamais pensé à mettre cette commande en pratique de cette maniére là mais finalement c’est plutôt logique. Je vais de ce pas vérifier 2 ou 3 choses du coup 😉

Merci pour cet article. J’ai appris quelque chose !

Je ne connaissais pas cette commande « /& ». Si cela peut permettre de détecter des pages valorisées par Google, pourquoi pas. C’est toujours bon à prendre, s’inspirer des meilleurs pour ensuite les dépasser.

Bisard, mais j’ai pas les même résultats que vous pour la FNAC.

Y a t’il une méthode spécifique?

@Realisite : j’ai l’impression que la commande ne fonctionne plus. Attendons de voir si c’est temporaire ou définitif…